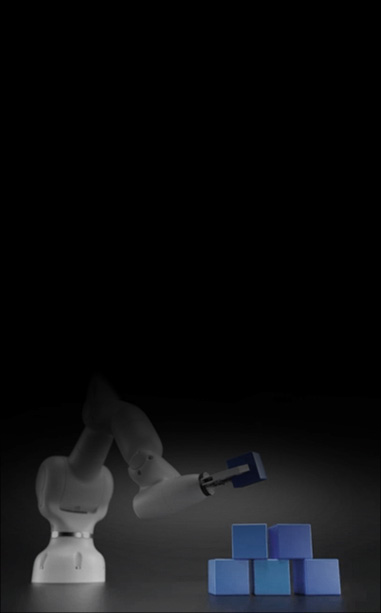

LinSeer MegaCube 是为本地AI开发打造的桌面级AI工作站,

搭载NVIDIA GB10 Grace Blackwell超级芯片,以“小体积+高性能+低功耗”为核心,单台设备即可

支持200B参数大模型推理与70B模型微调,双机级联轻松应对405B参数需求。

无需专业机房,在实验室、办公室等场景均可稳定运行,为AI开发团队提供“即插即用”的大模型算力支持。

搭载NVIDIA GB10 Grace Blackwell超级芯片,以“小体积+高性能+低功耗”为核心,单台设备即可

支持200B参数大模型推理与70B模型微调,双机级联轻松应对405B参数需求。

无需专业机房,在实验室、办公室等场景均可稳定运行,为AI开发团队提供“即插即用”的大模型算力支持。

LinSeer MegaCube 是为本地AI开发打造的桌面级AI工作站,搭载NVIDIA GB10 Grace Blackwell超级芯片,以“小体积+高性能+低功耗”为核心,单台设备即可支持200B参数大模型推理与70B模型微调,双机级联轻松应对405B参数需求。无需专业机房,在实验室、办公室等场景均可稳定运行,为AI开发团队提供“即插即用”的大模型算力支持。

-

1 petaFLOP Tensor性能(FP4)

1 petaFLOP Tensor性能(FP4)原生支持 FP4 精度,释放1 petaFLOP算力,推理速度较软件模拟 FP4 效率大幅提升,释放极致性能。

-

128GB

128GB

LPDDR5x统一内存单台设备轻松支持200B参数模型推理与

70B模型微调。单台设备轻松支持200B参数模型推理与70B模型微调。

-

灵活拓展性能

灵活拓展性能高性能 NVIDIA Connect-X网络可将两台

LinSeer MegaCube 系统连接在一起,

与多达 405B参数的AI 模型配合使用。高性能 NVIDIA Connect-X网络可将两台LinSeer MegaCube 系统连接在一起,与多达 405B参数的AI 模型配合使用。

-

极致小体积

极致小体积接近手掌大小,实验室、办公室部署空间零压力。

-

开箱即用&全栈AI软件支持

开箱即用&全栈AI软件支持预装NVIDIA DGX OS系统、CUDA、CUDA-X、RTX工具包及库,

支持PyTorch、TensorFlow、Matlab等。预装NVIDIA DGX OS系统、CUDA、CUDA-X、RTX工具包及库,支持PyTorch、TensorFlow、Matlab等。